| Docker 설치 관련 내용은 생략함 |

1. TensorRT 버전 확인

https://docs.nvidia.com/deeplearning/tensorrt/container-release-notes/running.html

::

About this task On a system with GPU support for NGC containers, when you run a container, the following occurs: The Docker engine loads the image into a container which runs the software. You define the runtime resources of the container by including the

docs.nvidia.com

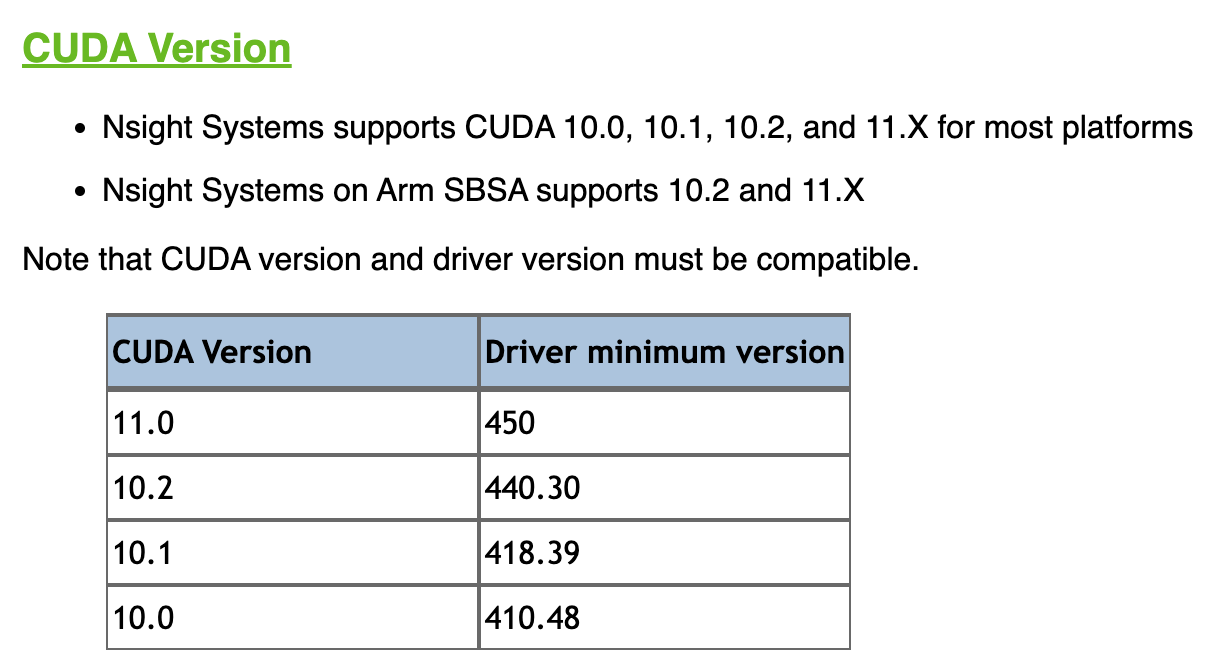

Container Release Node에서 TensorRT Container의 각 Release 버전과 CUDA 버전, Ubuntu 버전 등의 자신의 필요로 하는 버전과 일치하는 버전을 확인한다.

2. Docker Run

Docker run 명령어로 Image Download 및 shall 실행한다.

$ docker run --gpus <GPU> -it --name <NAME> nvcr.io/nvidia/tensorrt:<Version>-<pyver> bash예로 실행은 아래와 같다

$ docker run --gpus '"device=2"' -it -v /home/host/host_dir:/root/share_dir --name tensorrt_23.01_py3 nvcr.io/nvidia/tensorrt:23.01-py3 bash

3. Container 정상 동작 확인

-it 옵션으로 실행을 했기 때문에 바로 container 에 attach 및 shell이 실행된다

각 명령어로 정상 동작 하는지 확인한ㄷ,

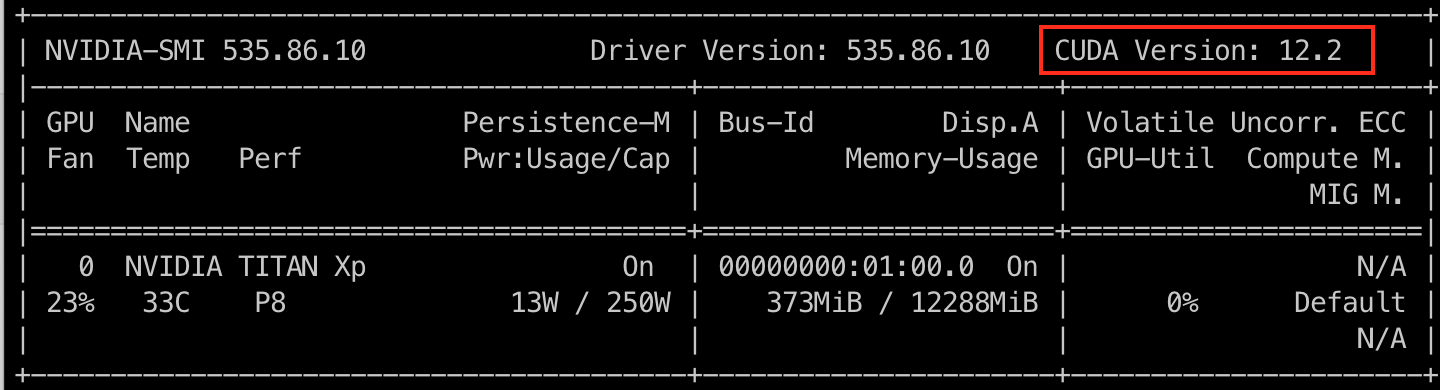

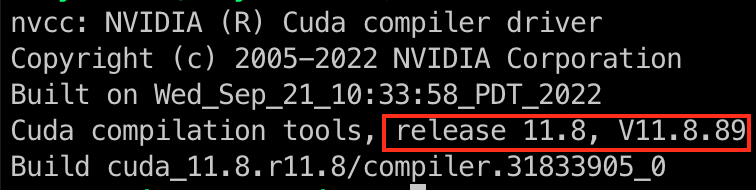

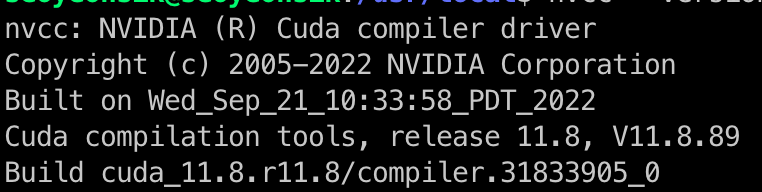

$ nvidia-smi # GPU 연결 및 CUDA Driver 정상 동작 확인

$ pip list | grep tensorrt # Tensor rt 버전 확인

4. Docker containe

Docker run 명령어로 container는 이미 생성되었다. 아래의 명령어로 생성된 container를 확인한다.

아래의 명령어중 -a를 붙여야 현재 container의 status가 start 상태가 아니더라도 확인이 가능한다.

$ docker container ls -a # Container 전체 리스트이후 다시 접속하기 위해서는 일반 docker container 와 같이 start/executing 을 통해 다시 접근 가능하다.

$ docker start <container name or hashnum>

$ docker exec -it <container name or hashnum> /bin/bash'개발, 웹, 블로그 > DeepLearning 상식' 카테고리의 다른 글

| ONNX Modifier 로 ONNX Model 수정 (0) | 2023.09.04 |

|---|---|

| CUDA Version 확인 방법 (0) | 2023.08.25 |

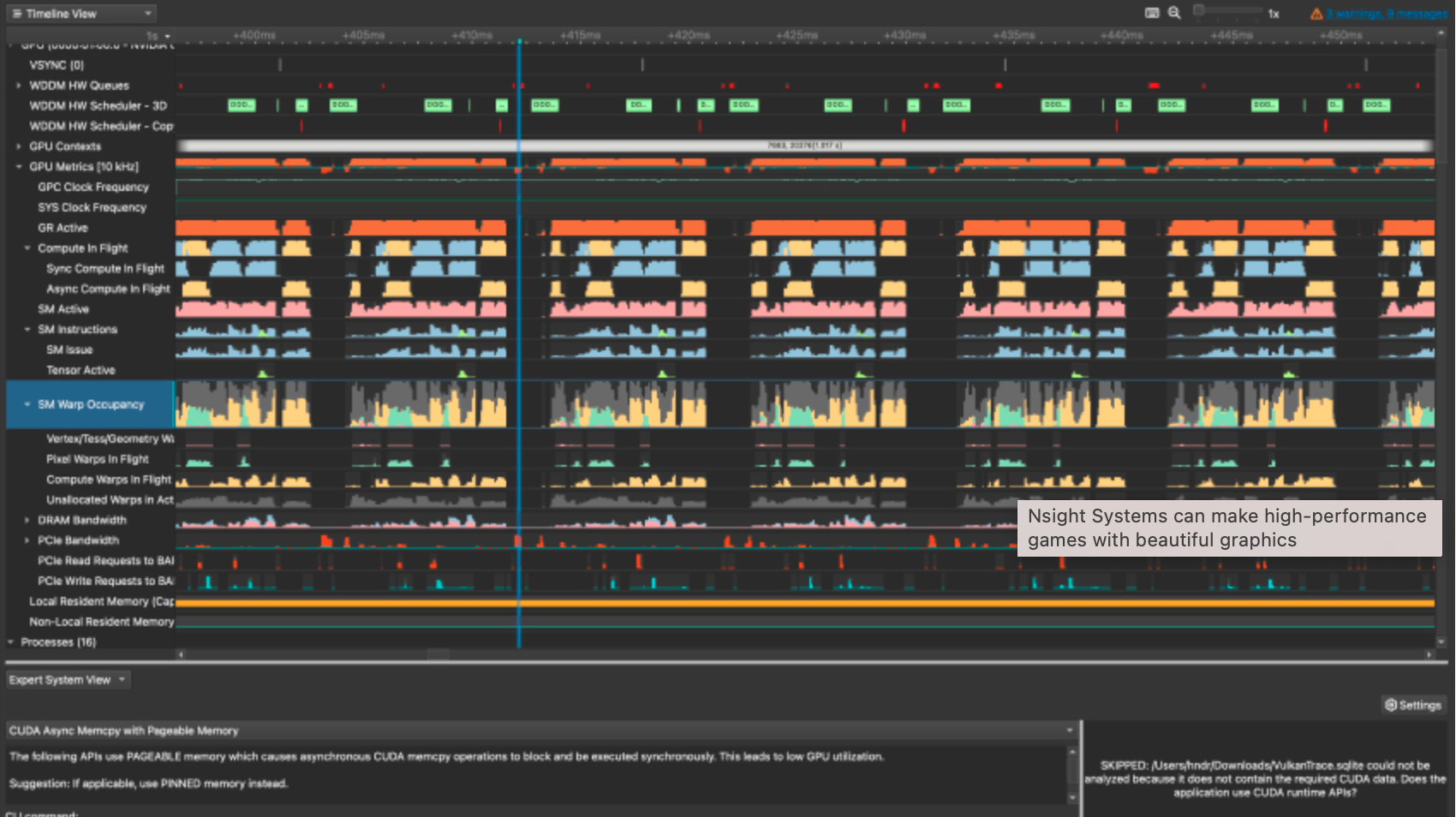

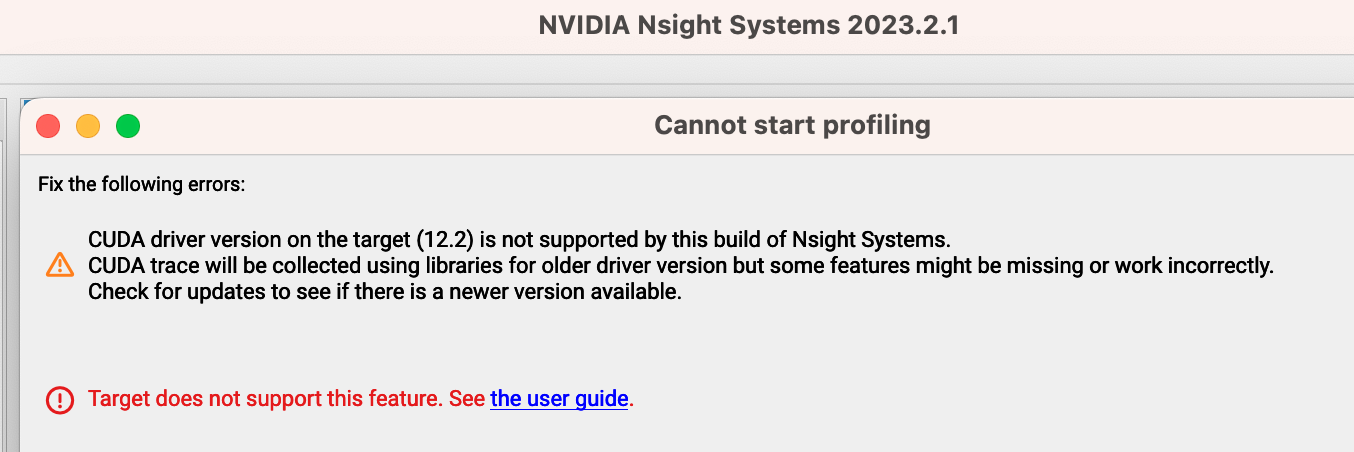

| NVidia CPU/GPU Profiling Tool NSight 설치 (0) | 2023.08.08 |